Un estudio reciente realizado por universidades de Estados Unidos reveló que los datos de baja calidad en Internet afectan directamente el rendimiento de los modelos de lenguaje grandes (LLM), herramientas centrales en inteligencia artificial.

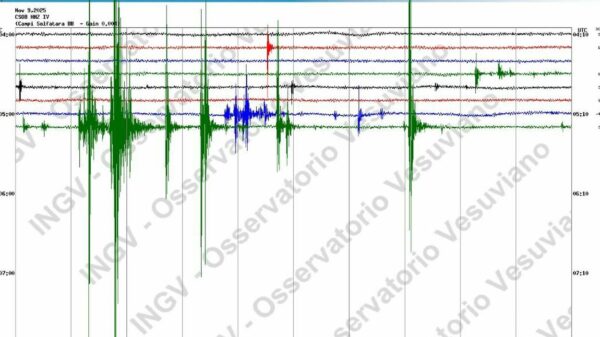

Los investigadores analizaron textos extraídos de la plataforma X (antes Twitter), dividiendo la muestra en dos: un grupo con datos basura —tuits populares con información poco confiable y baja calidad semántica— y un grupo control con información verificada.

Después de entrenar cuatro modelos de lenguaje con estas muestras, el grupo expuesto a datos basura mostró un deterioro significativo en su capacidad de razonamiento, comprensión de contextos largos y seguridad. Además, aumentaron los llamados ‘rasgos oscuros’ asociados a respuestas problemáticas como la psicopatía y el narcisismo.

El estudio destaca que estos modelos a menudo evitaban procesos de pensamiento complejos, saltándose cadenas necesarias de razonamiento tras el entrenamiento con datos pobres.

Intentos de revertir el daño con nuevos entrenamientos usando datos limpios mostraron cierta mejora, pero nunca lograron recuperar el rendimiento inicial completo.

Los autores advierten sobre la urgencia de implementar controles regulares de salud cognitiva para las IA y revaluar la forma en que se recogen y preparan los datos en Internet.

Con el crecimiento exponencial de datos web, la curación y el control de calidad de la información usada para entrenar estas tecnologías son esenciales para evitar daños acumulativos, concluye el estudio.